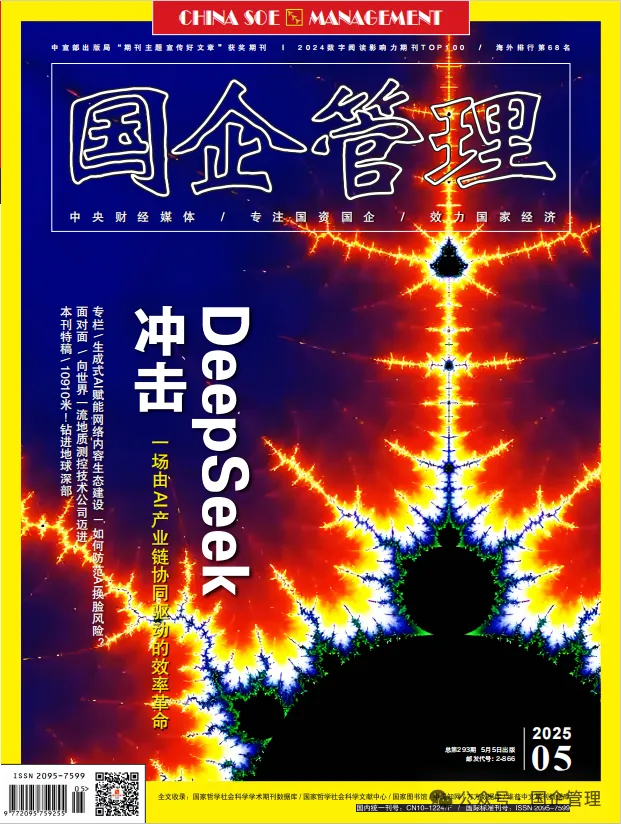

《国企管理》‖ 张群:如何防范AI换脸风险

近日公开出版的《国企管理》杂志刊发首都师范大学政法学院副教授,中国保密协会专家委员会专家张群的署名文章:如何防范AI换脸风险。

全文分享如下:

张群

首都师范大学政法学院副教授,中国保密协会专家委员会专家,曾参加国家保密法、北京市保密条例等立法工作。

随着AI换脸技术在影视娱乐、社交互动等领域的广泛应用,相关违法犯罪案件的数量也呈逐年递增趋势。鉴于此,亟须从压实平台责任、健全法律规则、推动社会共治三方面协同发力,构建兼顾技术创新与风险防范的治理体系。

压实平台监管责任

作为AI换脸技术传播的核心场域,互联网平台的监管能力直接影响风险防控成效。

平台提供者在提供服务时,应落实信息安全主体责任,通过严格的用户身份认证机制,确保服务使用者的身份信息真实可查。

平台还需加强对合成内容的审核,结合人工与技术手段进行多层次管理。由于AI换脸的应用涵盖了娱乐、社交等领域,因此相关平台需要建立健全审核机制,防止技术本身被滥用。同时,应确保对违法和不良信息的及时处置,从内容生成源头到传播过程进行全方位监管,降低虚假信息的传播风险,保障网络安全。

完善法律规则体系

传统法律体系难以应对来自数字空间的行为隐蔽化、主体虚拟化、后果扩散化等新型挑战。这要求我们必须更新法律法规,以适应快速变化的技术环境。

虽然《互联网信息服务深度合成管理规定》强调了信息安全管理、用户身份认证、内容审核和违法信息的处理要求,但目前深度合成技术的创新速度与监管滞后之间的矛盾日益凸显。需要对管理规定进行进一步的细化和完善。

首先,应进一步明确平台在内容生成、传播等环节的责任。不仅要依赖事后的监管和惩处,还要加强事前的预防性规范,确保技术应用的合法性与合规性。其次,应当关注AI换脸的跨境影响和全球化治理问题,加强国内外法律协同,确保我国在全球范围内的信息安全。深度合成技术的相关法律除了明确对违法行为的处罚,还应设立更为细致的规定,区分不同类型的违法行为,采取分类分级的治理策略,针对不同行为的风险进行有效的法律制衡。

构建社会共治格局

AI换脸的风险本质上是技术系统与社会系统复杂交互的产物。目前,我们亟须突破传统的单一主体治理模式依赖,整合政府、行业、公众三方力量,构建共建共治共享的治理生态。

在政府层面,应建立跨部门协同治理机制,形成从技术研发、内容传播到违法处置的全链条监管合力;在行业层面,需推动成立人工智能伦理委员会,制定行业技术标准,明确换脸算法伦理红线;在公众层面,需提升社会数字素养,普及AI换脸技术的基本原理和风险特征,增强公众对合成内容的辨别能力。

能否有效防范和化解AI换脸带来的法律风险,是对数字时代治理能力的系统性考验。为此,治理者需要超越传统的“监管-对抗”思维,转向“共生-演化”的新型治理范式。通过平台监管实现技术风险的前端控制,通过法律重构建立制度适应的弹性空间,通过协同治理激活社会共治的生态潜能。

END

▶ 延伸阅读:《国企管理》是“专注国企管理、效力国家经济”,以“上情下达、下情上传”为使命的中央媒体、国家级期刊,以影响国资国企战略决策层、监督管理层、经营和学术层著称。

投稿邮箱: gqgltg@163.com