终于有人把数据质量管理讲明白了!

摘自:《一本书讲透数据治理》

作者:石秀峰

数据质量管理

数据质量管理

数据质量,简单来说,就是指数据能否满足使用需求、能否准确表达实际对象、能否符合设定标准。

数据质量管理,是指对数据从计划、获取、存储、共享、维护、应用到消亡生命周期的每个阶段可能引发的数据质量问题,进行识别、测量、监控、预警等一系列管理活动,并通过改善和提高组织的管理水平使数据质量获得进一步提高。

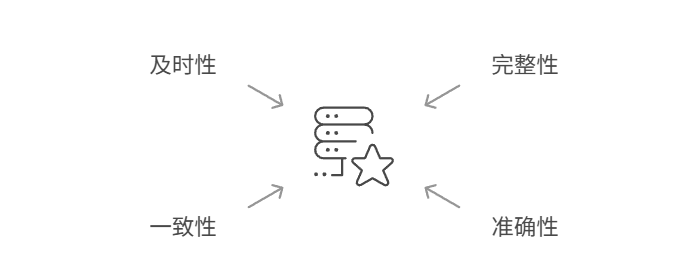

高质量的数据意味着它是完整的、准确的、一致的、及时的:

完整性:数据记录是否缺失,信息是否齐全。例如,订单信息中如果缺少商品ID或卖家ID,就属于完整性不足。

准确性:数据是否真实反映了业务事实。比如,卡点数据是否准确记录了门店交易时间,金额是否真实无误。

一致性:不同系统、不同来源的数据是否统一。例如,用户在多个系统中的会员等级、联系方式是否一致。

及时性:数据是否能在规定时间内更新,保证决策和分析的时效性,如秒级更新的交易数据,T+1的报表数据。

在实际业务中,低质量的数据往往体现在:销售数据延迟更新,导致库存调配失误;客户信息重复或错误,影响精准营销;财务数据遗漏,增加合规风险和审计压力;报表指标不统一,管理层决策出现偏差。

这些低质量数据会带来错误的决策或行动,造成经济损失、增加沟通成本、带来运营风险,甚至还有合规处罚和品牌危机,因此,将数据质量纳入到整体的数据治理和业务战略中,是企业数字化转型的重要前提。

在真正建立完善的质量管理体系之前,企业首先需要搞清楚——数据质量问题到底是如何产生的?问题出在哪些环节?又该如何分析?

问题分析

问题分析

数据生命周期五阶段

一个数据从诞生到消亡,通常要经历五个主要阶段:规划设计、数据创建、数据使用、数据老化、数据消亡,任何一个阶段如果缺少了规范管理和质量控制,都可能埋下隐患。具体如下:

规划设计阶段

在数据还未落地前,定义或建模不清晰就可能种下质量问题的种子。比如,数据模型标准不统一、字段含义模糊,导致后续录入和使用时出现歧义。

数据创建阶段

数据录入环节错误是最直观也是最常见的问题,无论是人工填报失误,还是接口数据同步错误,都可能直接造成数据缺失、格式异常、错误记录等。

数据使用阶段

数据在流转、调用、加工过程中,如果缺少一致性控制,很容易出现数据版本混乱、覆盖错误、解释偏差等问题,特别是在多系统并行的环境中,不同业务系统间数据标准不一致,往往导致数据孤岛和冲突。

数据老化阶段

随着时间推移,部分数据会失效过期,例如员工职位变更、客户联系方式变动,如果不及时更新,原本准确的数据也会逐渐失去使用价值。

数据消亡阶段

对不再使用的数据,如果缺乏规范的归档或销毁处理,可能不仅浪费存储资源,还容易引发合规和隐私风险。

数据质量问题三层面

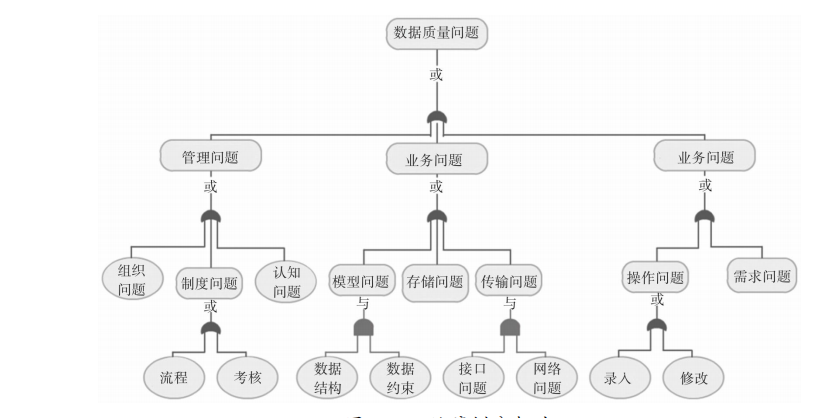

除了生命周期各阶段存在风险外,数据质量问题还可以从管理层面、业务层面、技术层面三个层面进一步拆解:

管理层面

企业数据标准不统一,不同子公司、部门各自为政;信息化建设与数据治理脱节,先建系统后治理数据的现象普遍存在;数据资产管理职责不清,缺乏有效的质量考核与激励机制。

业务应用层面

业务需求描述模糊,导致数据开发过程中理解偏差;数据录入流程不规范,缺少必要的校验和审核。

技术操作层面

数据建模、接口设计、数据迁移过程中存在设计漏洞或执行失误;数据传输过程缺乏完整性校验,容易在同步、复制、处理过程中产生错误。

质量问题分析工具

针对数据质量问题的根因分析,企业通常采用几种典型工具辅助展开:

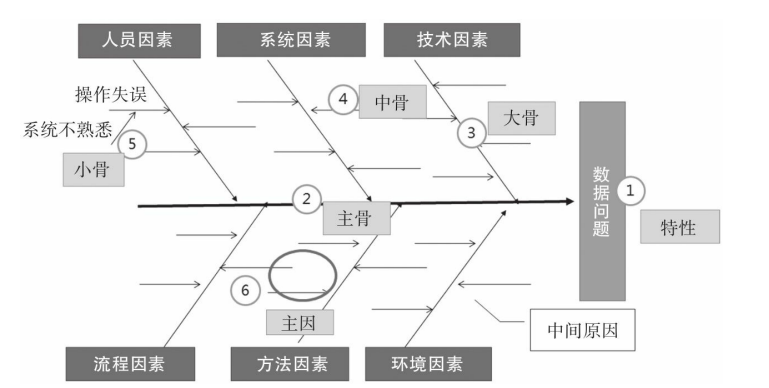

鱼骨图:梳理导致数据问题的多种可能因素,帮助系统化定位问题来源。

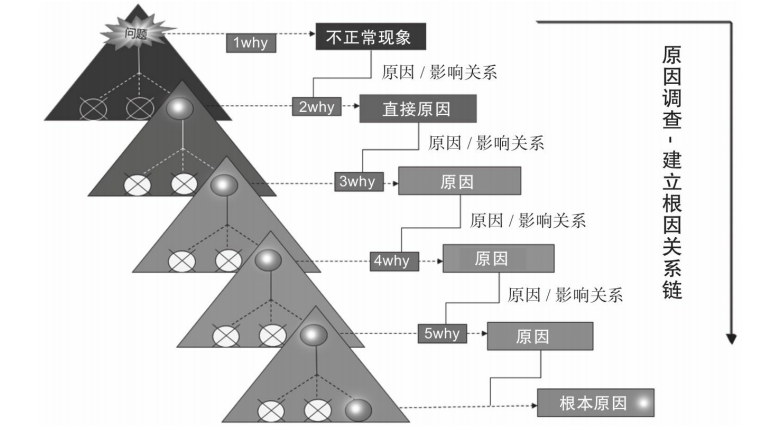

5Why分析法:通过连续五次“为什么”追问,挖掘出问题背后的深层原因。

故障树分析:自上而下推演,识别影响数据质量的各种组合条件。

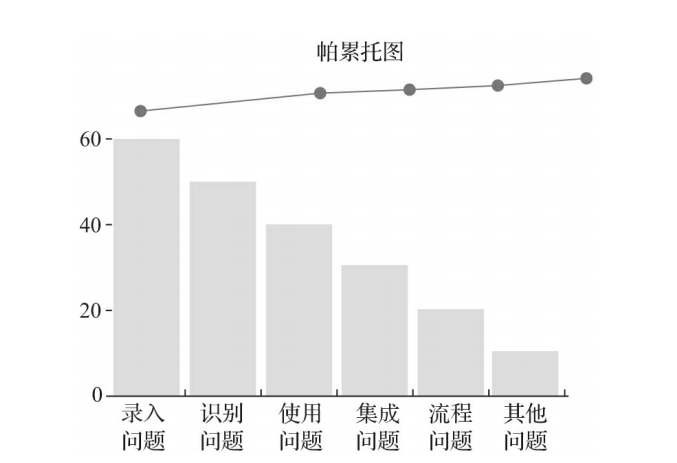

帕累托图:聚焦造成大部分数据问题的少数关键因素,优先攻克。

这些方法能够帮助企业理清复杂问题的脉络,避免停留在表面修补,从根本上提升数据治理的针对性和有效性。

管理框架

管理框架

很多企业在遇到数据质量问题时,通常的反应是临时找人查错修补,或者单纯依赖技术手段进行数据清洗,但这种仅靠一两次修正、零散的应对方法,很难从根本上解决问题。

数据质量的问题需要一个覆盖全生命周期、组织协同、标准统一的系统管理体系。系统化的数据质量管理,至少要具备以下几个核心特征:

全流程覆盖:从数据设计、创建、存储、流转、使用到销毁,每个环节都要有质量控制措施。

组织化管理:不仅仅是IT部门的事情,业务部门、管理层也要共同参与,明确责任分工。

标准化作业:统一数据定义、数据标准、质量规则,减少主观随意性。

持续性监控与改进:建立质量监控机制,持续评估、反馈和优化。

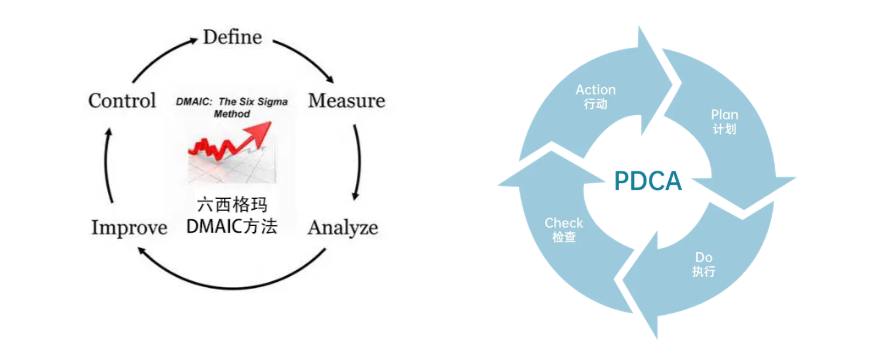

国际上比较成熟的数据质量管理思路,比如ISO 9001质量管理体系、六西格玛方法论,都强调“预防为主、全流程控制、持续优化”的理念。

具体来说,企业在构建数据质量管理体系时,可以遵循三个关键层面进行设计:

1、战略层:确立统一标准与治理目标

战略层是数据质量管理的顶层设计,决定了整体治理工作的方向和范围。主要包括:

制定统一的数据标准、质量指标体系,明确什么是“高质量数据”;明确数据治理的价值目标,比如提升决策准确性、提高客户体验、降低合规风险;将数据质量纳入企业整体数字化战略,而不仅仅作为技术项目孤立存在。

2、管理层:搭建组织架构与制度流程

管理层负责将战略意图具体化,转化为日常治理的组织保障和流程规范。主要任务包括:

设立专门的数据质量管理岗位或小组,如数据质量负责人(DQO)、数据治理委员会;规范数据质量管理流程,如问题上报、质量检查、异常处理、规则维护等;建立跨部门协同机制,明确各业务线、技术线在数据质量上的职责分工。

3、执行层:落实质量评估与问题监控

执行层是最接近数据操作现场的一层,需要把管理制度落到具体行动中。主要内容包括:

实施数据质量评估,比如通过完整性、准确性、一致性、及时性等维度对数据进行周期性检查;建立数据质量监控系统,实时跟踪数据异常,生成质量报告和预警提示;配合数据开发、数据迁移等重要流程节点,进行质量把控,防止问题扩散。

评估体系

评估体系

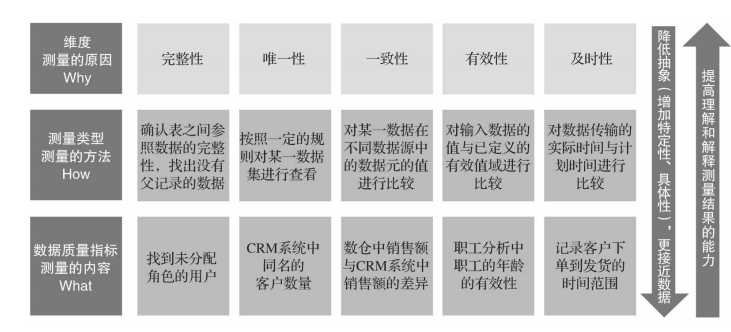

实际数据管理过程中,对于数据质量好坏的评估也十分关键,企业如果还停留于“凭经验”、“靠感觉”甚至“有没有出错”的数据治理层面上,就不可避免产生各自为政、口说无凭的混乱局面。

不同场景对质量要求不同,企业通过设立明确的数据质量指标、量化的对比评估体系,能够有效实现精准定位问题、持续优化改进,提升数据资产的可信度和使用价值。

国际通用标准:DQAF 框架

DQAF(Data Quality Assessment Framework,数据质量评估框架)是国际货币基金组织(IMF)以联合国政府统计基本原则为基础构建的数据质量评估框架体系,于2003年7月正式发布,是目前全球认可度较高的质量评估体系之一。

该框架的核心思想是:从多个维度出发,对数据质量进行系统评估,最终支撑数据可用性和可信度。如下图所示:

在本地化落地时,企业可基于 DQAF 思路,结合自身业务需求和治理成熟度,制定一套“自定义的数据质量评估体系”,部署质量检测模块,实现问题自动识别、指标可视化呈现、趋势持续追踪,现有的国产数据平台例如FineDataLink就支持完整的数据质量检测体系:

通过字段级规则检测,校验关键数据字段的合法性,如利用正则表达式验证电话号码、证件号等格式规范;

通过完整性检测机制,进行主键唯一性校验,设置行占比阈值,确保数据集内无漏报、重报情况;

配置脏数据监控体系,对敏感或核心数据实行零容忍策略,实时捕捉脏数据并告警,及时防止数据污染;

结合ETL流程进行数据标准化处理(如ODS→DW→DM分层治理),系统性清理作废、非法、空值数据,提升整体数据可用性。

落地方法

落地方法

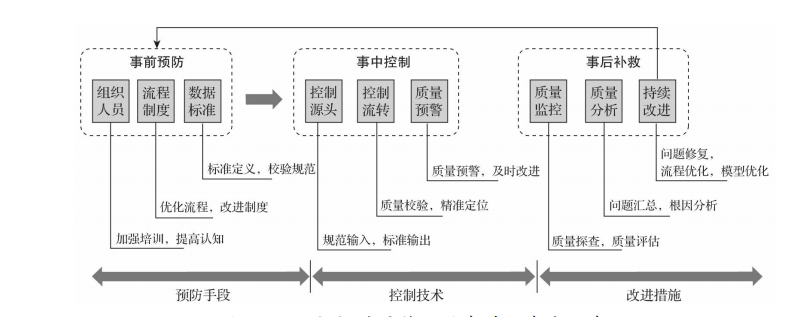

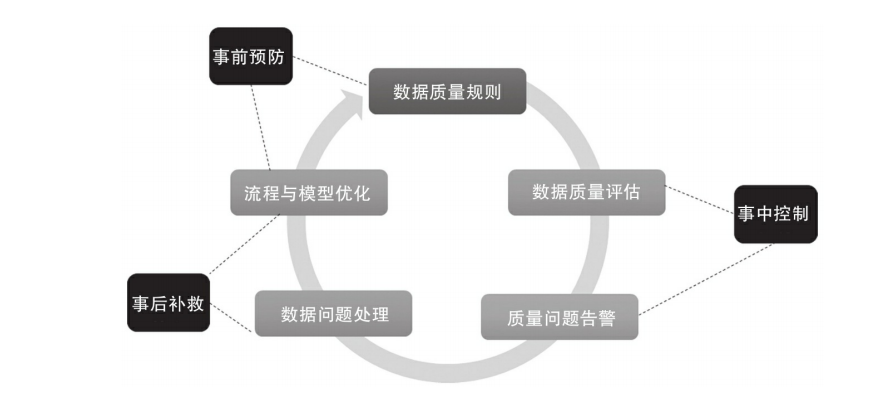

科学的数据质量管理,需要遵循“事前预防、事中控制、事后补救”的闭环思路,针对不同阶段,采取针对性的策略与技术措施,有效降低问题发生率,提升数据使用的可靠性与安全性。

1、事前预防:防患于未然

在数据质量管理中,事前预防是最重要也是最具性价比的一环,主要措施包括:

加强组织建设

在数据治理整体架构下,设置专门的数据质量管理岗位或角色,并加强相关人员的技能培训,提高质量意识。

落实数据标准化

建立统一的数据建模标准、主数据和参考数据标准、指标数据标准等,确保数据从源头定义清晰、结构规范。

制定流程制度保障

明确数据质量管理流程和相关管理制度,为后续治理工作提供制度性支撑。

通过事前标准化和组织保障,可以大幅减少数据录入、同步、加工过程中的错误风险,从源头提升数据质量。

2、事中控制:动态监控,精准把关

即使有了完善的标准和流程,数据在实际流转过程中依然可能出现问题,因此需要在事中进行有效控制:

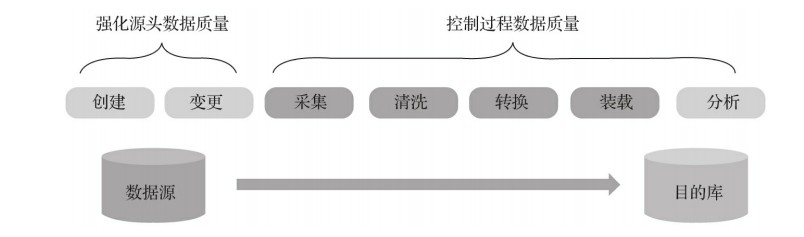

加强数据源头管理

通过自动化数据录入、字典校验、人工审核等手段,确保数据一开始就符合质量要求。

流转过程控制

在数据采集、存储、传输、处理、分析等每一个环节,嵌入质量检测机制,实时发现并处置异常。

持续质量监控与更新

更新质量规则,适配业务变化;通过数据质量监控系统实时预警异常数据;定期生成数据质量报告,形成治理闭环。

事中控制的关键,是将质量把关工作前置到每个数据操作流程中,做到问题及时发现、及时纠正,防止小问题演变为系统性风险。

3、事后补救:及时止损,持续优化

尽管有预防和控制,但在复杂业务环境下,仍然难以做到零错误,因此事后补救机制同样必不可少:

定期开展质量检查

对某些不适合持续实时监控的数据,定期进行质量复检,评估状态变化。

主动清理与补救措施

组织专项清洗,包括:清理重复数据、派生数据,补充缺失字段,处理异常值和逻辑错误。

持续改进机制

依托PDCA循环思路,不断总结问题根因,优化质量规则与流程,实现持续性改进。

事后补救的目标,是在问题发生后尽快修复,最大程度降低对业务、合规、客户体验的负面影响,同时将经验沉淀,反哺到事前预防和事中控制中。

综上所述,想要做好数据质量管理,就必须每一步依据专业的方法、适配的工具,从体系搭建到评估量化,再到治理落地,形成覆盖数据全生命周期的治理闭环,以支撑企业在数字化的浪潮下,构建起强有力的底座。

<END>

注:本文内容摘自我的专注《一本书讲透数据治理》,欢迎大家阅读。

据统计,99%的数据大咖都关注了这个公众号

👇

数据治理并不是什么‘高端大气上档次的活,不仅都是苦活、累活,还是个受力不讨好,经常背锅,领导看不见价值的活。你要不要入坑?

-

数据治理:说起来容易,做起来难? -

数据治理:90%的人搞不清的事情 -

从传统数据治理转向主动数据治理!

-

小数据治理靠人工,大数据治理靠智能 -

数据治理治什么?在哪治?怎么治? -

数据治理项目失败,90%都是被这样搞垮的!